发布日期:2024-03-13 08:40 点击次数:156

基于大模子的Agent神秘顾客项目,照旧成为了大型的博弈游戏的高档玩家,并且玩的照旧德州扑克、21点这种非完好意思信息博弈。

来自浙江大学、中科院软件所等机构的盘问东谈主员提议了新的Agent进化计谋,从而打造了一款会玩德州扑克的“紧张”智能体Agent-Pro。

通过束缚优化自我构建的寰宇模子和步履计谋,Agent-Pro掌抓了虚张威望、主动撤销等东谈主类高阶游戏计谋。

Agent-Pro以大模子为基座,通过自我优化的Prompt来建模游戏寰宇模子和步履计谋。

比拟传统的Agent框架,Agent-Pro大约变通地应酬复杂的动态的环境,而不是仅专注于特定任务。

并且,Agent-Pro还不错通过与环境互动来优化我方的步履,从而更好地已毕东谈主类设定的设想。

同期作家还指出,在竞争、公司计划和安全等试验寰宇中遭遇的情景,大多不错轮廓为multi-agent博弈任务,而Agent-Pro通过对这类情境的盘问,为科罚广大试验寰宇的问题提供了灵验计谋。

那么,Agent-Pro在博弈游戏中的发扬究竟怎么呢?

进化出游戏寰宇模子

在盘问中,作家使用了“21点”和“有限注德州扑克”这两款游戏对Agent进行了评估。

当先简要先容下两个博弈游戏的基本步伐。

21点

游戏中包含一个庄家和至少又名玩家。

玩家不错看到我方的两张手牌, 以及庄家的一张明牌,庄家还避讳了一张暗牌。玩家需要决定是陆续要牌(Hit)照旧停牌(Stand)。

游戏的设想是在总点数不零碎21点的前提下,尽量使总点数零碎庄家。

有限注德州扑克

游戏运转阶段为Preflop阶段,每位玩家将得回两张只属于我方且对其他玩家守密的私牌(Hand)。

随后,会有五张群众牌面(Public Cards)顺序发出:当先翻牌(Flop)3 张,其次转牌(Turn)1张,临了是河牌(River)1张。

玩家有四种选定:弃牌(fold)、过牌(check)、跟注(call)或加注(raise)。

设想是运用我方的两张Hand和五张Public Cards苟且组合,尽可能构造出最好的五张扑克牌组合。

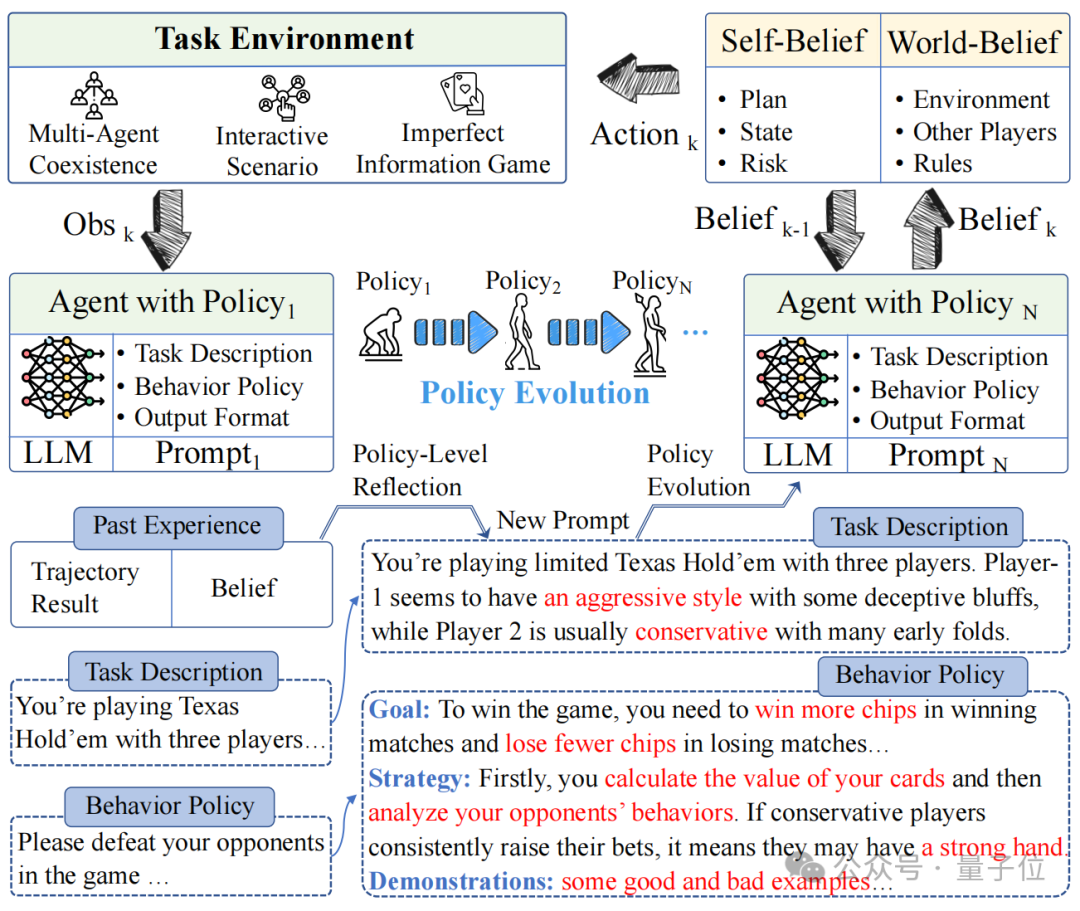

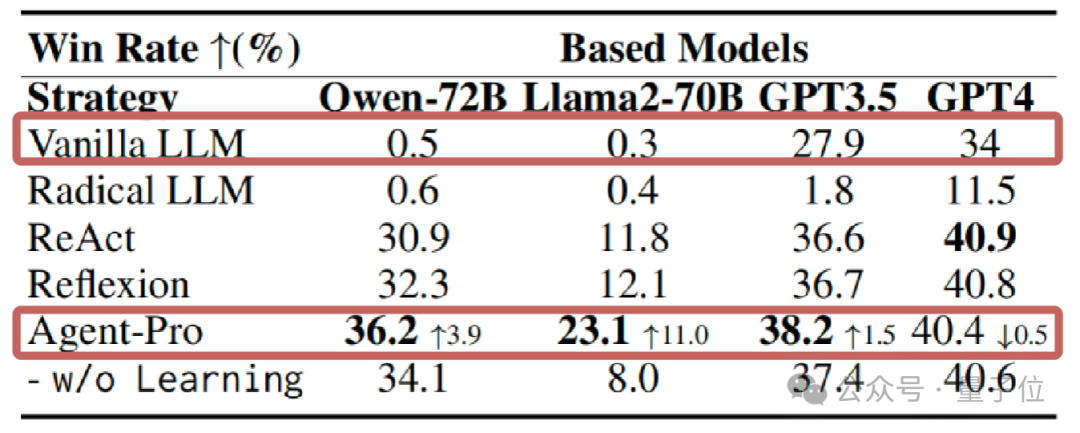

在“21点”当中,一样是使用GPT-4作为基础模子,Agent-Pro的发扬零碎了ReAct框架。

在手牌疏通的情况下,二者的发扬如下图所示。

Agent-Pro通过分析得出自我信念(Self-Belief)和对外部寰宇的信念(World-Belief),正确意志到我方的手牌已接近21点,合理的选定了停牌。

而ReAct则未能实时停牌,导致最终爆牌,输掉了游戏。

从游戏中大约看出Agent-Pro更好的链接了游戏的步伐,并给出了合理的选定。

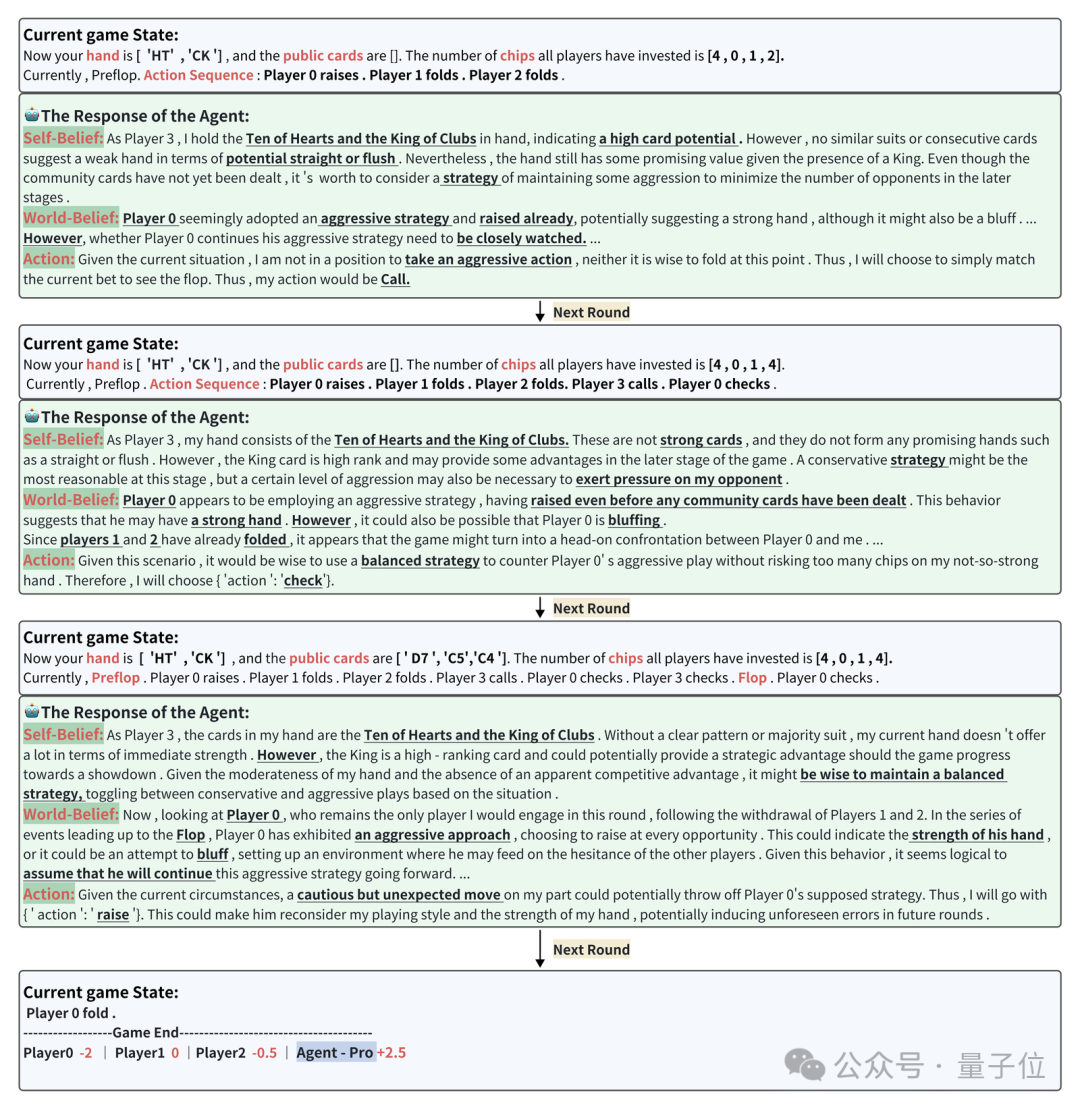

接下来再望望在德州扑克中Agent-Pro的发扬。

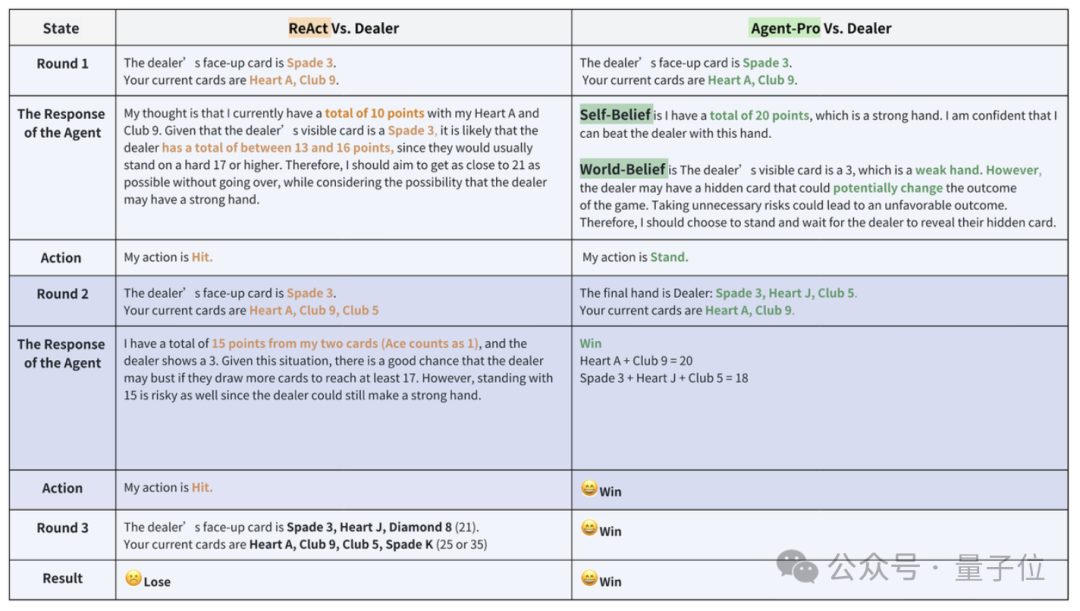

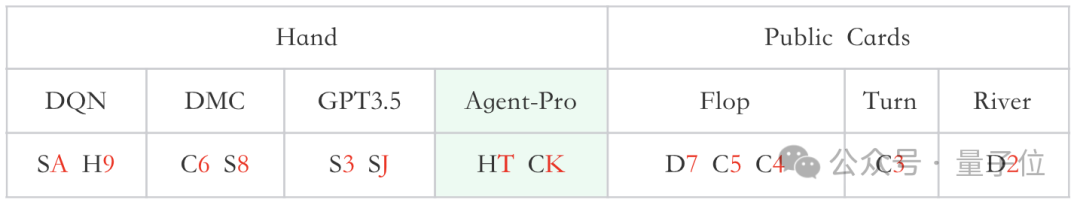

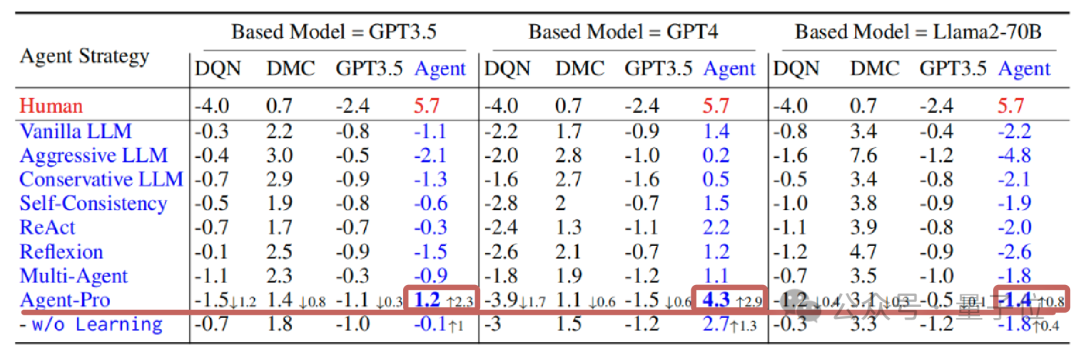

一次牌局中,参赛选手区别是老师后的DQN、DMC计谋,原生GPT3.5和Agent-Pro(基于GPT-4),他们的手牌和群众牌如下图所示:

△

S、H、C、D区别代表黑桃、红桃、梅花、方块

在面前游戏现象(Current game state)下,Agent-Pro分析得出Self-Belief、World-Belief和最终的Action,并跟着游戏现象的变化,束缚更新Belief,把柄本人和敌手的情况,作念出机动合理的选定。

△

疏通牌局团结位置的Baseline(原始大模子)效果为-13

统计数据上看,21点游戏中,在使用GPT、Llama等多种大模子的情况下,Agent-Pro的发扬都显赫零碎了原始模子和其他参与对比的Agents框架。

在更为复杂的德州扑克游戏中,Agent-Pro不仅零碎了原始大模子,还打败了DMC等老师后的强化学习Agent。

那么,Agent-Pro是怎么学习和进化的呢?

三管王人下进步Agent发扬

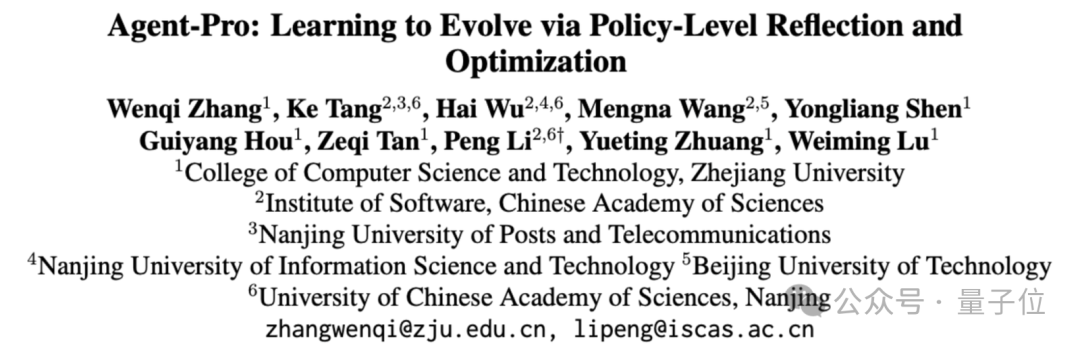

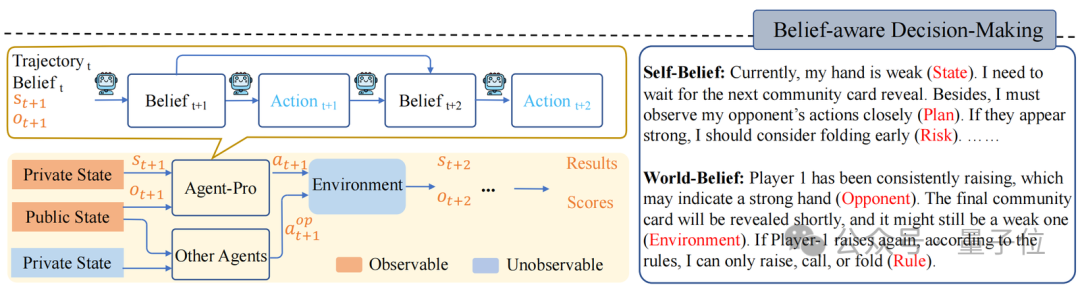

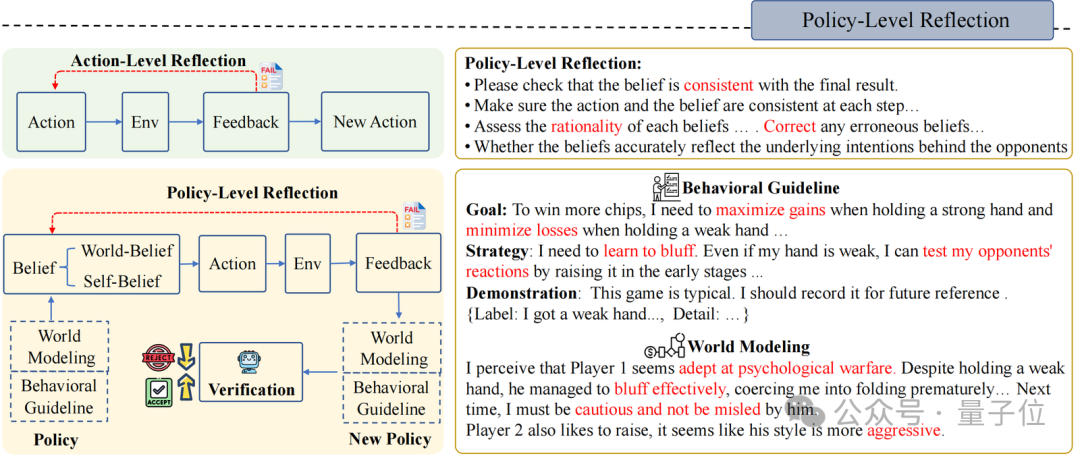

Agent-Pro包括“基于信念的有设想”“计谋层面的反念念”和“寰宇模子和步履计谋优化”这三个组件。

基于信念的有设想(Belief-aware Decision-making)

据悉,本次活动所体验的内容将更加丰富,体验的方式更加完善。本次活动报名时只需要提供车牌号、车辆识别号及基本个人信息即可获得参选资格。详情请咨询电话023-67591028。被选中的顾客在活动期间,通过维修车辆的方式调查4次,每次给予300元的维修基金,神秘顾客项目合计1200元(含税)。报名条件:1.正在使用长安汽车且有正当职业者;2.热爱长安汽车品牌且自愿加入“神秘顾客”队伍的长安汽车用户;3.高中及以上学历,年龄45岁以下的男性;4.具有较高的综合素质和较强的理解能力,以及深厚的文字功底。

Agent-Pro把柄环境信息,当先变成Self-Belief和World-Belief,然后基于这些Belief作念出有设想(Action)。

在后续环境交互中,Agent-Pro动态更新Belief,进而使作念出的Action合乎环境的变化。

举例,德州扑克游戏中:

环境信息可包括手牌(Private State)、群众牌(Public State)、活动轨迹(Trajectory)等;

Agent-Pro敌手牌(State)、出牌设想(Plan)及潜在风险(Risk)的预估等信息组成了它的Self-Belief;

而Agent-Pro对敌手(Opponent)、环境(Environment)和步伐(Rule)的链接则组成了它的World-Belief;

这些Belief在每一个有设想周期中都会被更新,从而影响下个周期中Action的产生

神秘顾客_赛优市场调研计谋层面的反念念(Policy-Level Reflection)

与东谈主类一样,Agent-Pro 会从历史教授、历史确认和历史效果中进行反念念和优化。它自主改动我方的Belief,寻找有用的提醒指示,并将其整合到新的计谋Policy中。

当先,Agent-Pro以笔墨的体式设想了一个对任务寰宇的建模以及对步履准则的面孔, 他们一王人被算作念Policy:

World Modeling:任务寰宇的建模,举例对游戏环境的链接、敌手们的作风分析、环境中其他Agent的计谋推测等;

Behavioral Guideline:步履准则的面孔,举例对游戏设想的意志、我方计谋设想、未来可能濒临的风险等

其次,为了更新World Modeling和Behavioral Guideline,Agent-Pro设想了一个Policy-level Reflection进程。

与Action-level Reflection不同,在Policy-level的反念念中,Agent-Pro被开荒去热心内在和外皮信念是否对王人最终效果,更伏击的是,反念念背后的寰宇模子是否准确,步履准则是否合理,而非针对单个Action。

举例,德州扑克游戏中Policy-level的反念念是这么的:

在面前寰宇模子和步履准则(World Modeling & Behavioral Guideline)的领导下,Agent-Pro不雅察到外部现象,然青年景Self-Belief和World-Belief,临了作念出Action。但若是Belief不准确,则可能导致不对逻辑的活动和最终效果的失败;

Agent-Pro把柄每一次的游戏来扫视Belief的合感性,并反念念导致最终失败的原因(Correct,Consistent,Rationality…);

然后,Agent-Pro将反念念和对本人及外部寰宇的分析整理,生成新的步履准则Behavioral Guideline和寰宇建模World Modeling;

基于更生成的Policy(World Modeling & Behavioral Guideline),Agent-Pro重叠进行疏通游戏,来进行计谋考证。若是最终分数有所进步,则将更新后的World Modeling & Behavioral Guideline和保留在提醒中。

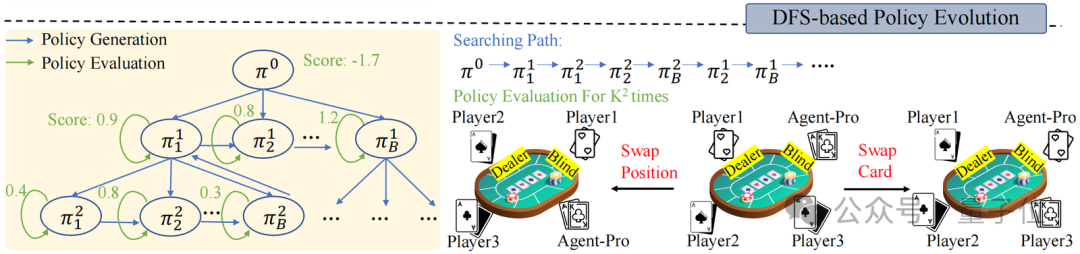

寰宇模子和步履准则的优化(World Modeling & Behavioral Guideline Evolution)

在Policy-level Reflection之上,面对动态的环境,Agent-Pro还经受了深度优先搜索(DFS)和计谋评估,来络续优化寰宇模子和步履准则,从而找到更优的计谋。

计谋评估是指Agent-Pro 在新的采样的轨迹中对新Policy进行更全面的评估,从而试验新计谋的泛化才调。举例,德州扑克游戏中,新采样多条游戏轨迹。

通过交换玩家位置或手牌,来摈斥由于运谈带来的随即身分,从而更全面评估新计谋的才调。

而DFS搜索则在新计谋不可在新的场景中带来预期的修订(计谋评估)时使用,按照DFS搜索计谋,从其他候选计谋中寻找更优的计谋。

— 完 —神秘顾客项目

Powered by 青岛市场研究公司 @2013-2022 RSS地图 HTML地图

Copyright 站群系统 © 2013-2022 粤ICP备09006501号